ملفات ساخنة

هكذا كانت الحياة قبل الذكاء الاصطناعي.. وهكذا تستمر من بعده

التعلم العميق أداة تقوي الديمقراطية أو تقوضها

عند الحديث عن سلبيات الذكاء الاصطناعي غالبا ما تضع المناقشات الصين في مواجهة الولايات المتحدة (قوى الخير في مواجهة قوى الشر)، ولا يتم التركيز أو حتى الانتباه إلى حقيقة أن تأثيرات الذكاء الاصطناعي والتعلم الآلي لا تقتصر على التنافس بين القوى الكبرى بل تطال القوى المتنافسة من الداخل.

باستثناء أصوات منفردة تصدر عن علماء اجتماع ومحللين سياسيين أو منظمات المجتمع المدني، لم يتوقف العالم المبهور بالثورة المعلوماتية والذكاء الاصطناعي طويلا لدراسة التأثيرات التي خلفتها هذه التقنيات على المجتمع عموما وعلى الديمقراطية بشكل خاص.

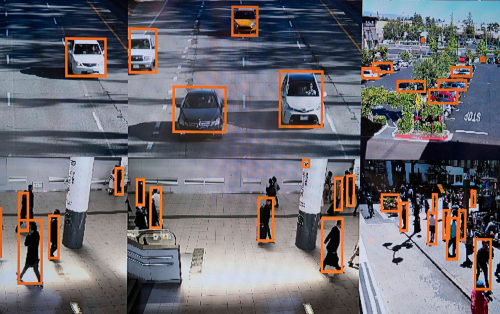

ما نسمعه حتى اليوم، خاصة من السياسيين، هو تحذيرات من أن الذكاء الاصطناعي المدعوم بالتعلم الآلي سيوفر للأنظمة الدكتاتورية المستبدة أدوات لم يسبق أن تخيلتها، تسمح لها بمراقبة الرعية وتقصي تحركاتها ومعرفة ما يدور في رأس كل فرد من أفرادها.

ولكن، هل يكفي أن يكون المجتمع ديمقراطيا كما يدعون ليكون محصنا من الآثار السلبية لهذه التكنولوجيا؟

ثمار المنافسة

يبدو أننا جميعا وقعنا في الفخ، واعتبرنا أن الديمقراطية كفيلة بتأمين الحماية لنا.

السباق المحموم الذي قبلنا به جميعا باعتباره ضرورة بين الدول الديمقراطية وفي مقدمتها الولايات المتحدة والدول المستبدة وفي طليعتها الصين، قد يكون ضروريا لحماية الأمن القومي كما تقول حكومات تلك الدول. الفائز في النهاية سيمتلك نفط الألفية الثالثة ويتحكم بالعالم.

وإن كان المورد الأساسي في اقتصاديات المستقبل هو البيانات، فإن الصين بسكانها الذين يتجاوز عددهم المليار ونصف المليار نسمة، وأنظمة حمايتها المتساهلة التي تتيح مراقبة الدولة، يبدو مقدرا لها الفوز في السباق.

ولكن عدد السكان ليس عامل الحسم الوحيد، هناك النظام التعليمي والكفاءات العلمية، التي قد تمنح الولايات المتحدة فرصة للخروج منتصرة.

وبحسب المحللين والخبراء، المنتصر سيكافئه الذكاء الاصطناعي بطبيعة الحال ويمنحه تفوقا اقتصاديا وعسكريا شاملا.

أول “ثمار المنافسة” على كسب الرهان هو إعلان الحرب على العولمة، واشتعال النار التي ظننا أنها بردت بين الولايات المتحدة والصين.

إلا أن حصر التفكير عند الحديث عن الذكاء الاصطناعي في التسابق على الهيمنة، يغفل بعدا جوهريا وهو قدرة الذكاء الاصطناعي على خلق تحول في الممارسة السياسية داخل الدول نفسها.

وبينما يركز العالم على الآثار المترتبة عن الذكاء الاصطناعي على العلاقات السياسية الدولية، يتجاهل قدرة هذه التكنولوجيا على إحداث تحولات لا ينجو منها نظام ديمقراطي أو استبدادي.

حتى هذا اليوم كان العالم مشغولا في متابعة الآثار المترتبة عن هذه التحولات في النظم الاستبدادية. وكانت الصين هي النموذج المفضل، فهي الاقتصاد الأقوى، وما انطبق عليها يمكن تعميمه على سائر النظم الاستبدادية في العالم.

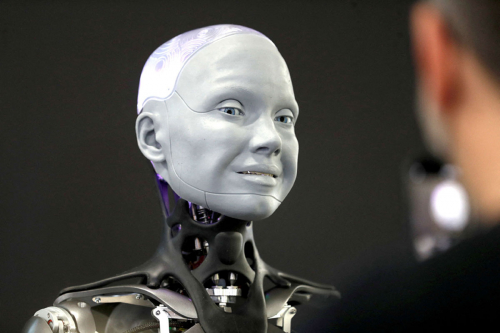

التأثيرات العميقة للذكاء الاصطناعي بدأت بشكل أوضح مع ظهور ما يطلق عليه اليوم التعلم الآلي، الذي تكمن خطورته بمنحه تكنولوجيا الذكاء القدرة على التطور الذاتي.

هناك مخاوف في العالم الذي يوصف بالديمقراطي من أن يزيد التعلم الآلي من الاستقطاب ويعزز الانقسام السياسي، وينشر على نطاق واسع خطابا مزيفا يتوارى خلف معلومات مضللة.

ومثلما يعكس التعلم الآلي انقسامات الديمقراطية ويعززها، فإنه وفق محللين يربك الأنظمة الاستبدادية و”يخلق مظهرا زائفا للإجماع ويخفي التصدعات المجتمعية الكامنة حتى فوات الأوان”.

رغم أن الرواد الأوائل لم يتوقعوا الكيفية التي سيهيمن بها التعلم الآلي على الذكاء الاصطناعي، إلا أن تطوره يتناسب مع طريقة تفكيرهم. نجد هذا بوضوح مع العالم الأميركي الاقتصادي هربرت سايمون، (توفي عام 2001) الذي أدرك أن “تكنولوجيا الذكاء الاصطناعي تشترك مع الأسواق والبيروقراطيات والمؤسسات السياسية أكثر من التطبيقات الهندسية البسيطة”. ووصف رائد آخر في مجال الذكاء الاصطناعي، نوربرت فينر، (توفي عام 1964) الذكاء الاصطناعي بأنه نظام “سيبراني” يمكنه الاستجابة والتكيف مع ردود الفعل.

أنظمة سيبرانية

اليوم يستخدم فيسبوك وغوغل التعلم الآلي كمحرك تحليلي لنظام تصحيح ذاتي، يقوم بتحديث فهمه للبيانات باستمرار اعتمادا على ما إذا كانت توقعاته تنجح أو تفشل. هذه العلاقة بين التحليل الإحصائي والتغذية المرتدة هي التي جعلت من التعلم الآلي قوة هائلة، وهي ما ركزت عليه أعمال سايمون وفينر.

فالديمقراطية والدكتاتورية هي أنظمة سيبرانية أيضا. في كلا الشكلين، تسن الحكومات سياسات، ثم تحاول معرفة ما إذا كانت هذه السياسات قد نجحت أم فشلت.

في الديمقراطيات يوفر التحليل ردود فعل قوية حول ما إذا كان نهج معين يعمل حقا. أما في الأنظمة الاستبدادية قبل عصر المعلومات، فقد تم الاعتماد على الاستخبارات الداخلية وعلى استطلاعات الرأي السرية في محاولة معرفة ما تعتقده الرعية.

والآن، يعمل التعلم الآلي على إزاحة الأشكال التقليدية للتغذية الراجعة حيث تسهل التقنيات الجديدة المعلومات المضللة وتفاقم التحيزات القائمة، مع أخذ التحيز المخفي في البيانات وتحويله بثقة إلى تأكيدات غير صحيحة.

بالنسبة إلى قادة الأنظمة المستبدة الذين يتخبطون في الظلام، يبدو التعلم الآلي استجابة لصلواتهم. حيث يمكن لهذه التكنولوجيا أن تخبرهم ما إذا كان رعاياهم راضين عما يفعلونه دون متاعب الدراسات الاستقصائية، أو المخاطر السياسية الناجمة عن المناقشات المفتوحة والانتخابات. ولهذا السبب، يشعر العديد من المراقبين بالقلق من أن التقدم في الذكاء الاصطناعي لن يؤدي إلّا إلى تقوية يد الدكتاتوريين وتمكينهم.

ولكن الحقيقة أكثر تعقيدا. فمن الواضح أن التحيز يمثل مشكلة للديمقراطيات أيضا. ولكن نظرا لأنه أكثر وضوحا، يمكن للمواطنين تخفيفه من خلال أشكال أخرى من ردود الفعل. على سبيل المثال، عندما ترى مجموعة عرقية أن خوارزميات التوظيف متحيزة ضدها، يمكنها الاحتجاج والبحث عن الإنصاف مع بعض فرص النجاح.

وسواء كانت الأنظمة الاستبدادية أقل عرضة للتحيز من الديمقراطيات أو أكثر عرضة لذلك، إلا أن التحيز في المجتمعات الاستبدادية غير مرئي غالبا، خاصة بالنسبة إلى صناع القرار في القمة. وهذا يجعل تصحيح الأمر أكثر صعوبة، حتى لو كان القادة يرون أن شيئا ما يحتاج إلى تصحيح.

وخلافا للطرق التقليدية، يمكن للذكاء الاصطناعي أن يقوض الأنظمة الاستبدادية من خلال تعزيز أيديولوجياتها وأوهامها الخاصة على حساب فهم أدق للعالم الحقيقي. وقد تكتشف البلدان الديمقراطية أن التحدي الرئيسي في القرن الحادي والعشرين عندما يتعلق الأمر بالذكاء الاصطناعي لا يتلخص في الفوز في معركة الهيمنة التكنولوجية. بدلا من ذلك، سيتعين عليها التعامل مع البلدان الاستبدادية التي تجد نفسها في خضم دوامة من الوهم يغذيها الذكاء الاصطناعي.

معظم المناقشات حول الذكاء الاصطناعي تتعلق بالتعلم الآلي وعلاقته بالخوارزميات الإحصائية التي تستكشف العلاقة بين البيانات. هذه الخوارزميات قائمة على التخمينات: هل ستفوز استراتيجية الشطرنج هذه باللعبة في عشر حركات؟ ما هي الكلمة التالية في هذه الجملة نصف المكتملة؟ ويمكن لما يسمّى بالدالة الموضوعية، وهي وسيلة رياضية لتسجيل النتائج، أن تكافئ الخوارزمية إذا خمنت بشكل صحيح. ببساطة هذه العملية هي الطريقة التي تعمل بها أنظمة الذكاء الاصطناعي التجارية.

على سبيل المثال، يريد يوتيوب الحفاظ على تفاعل المستخدمين، ودفعهم لمشاهدة المزيد من مقاطع الفيديو حتى يستمروا في مشاهدة الإعلانات، وذلك بتصميم الوظيفة الموضوعية لتحقيق أقصى قدر من مشاركة المستخدم. وتحاول الخوارزمية عرض المحتوى الذي يبقي عيون المستخدم على الصفحة، واعتمادا على ما إذا كان التخمين صحيحا أم خاطئا، تقوم الخوارزمية بتحديث نموذجها للاحتمال القادم الذي يتلقى استجابة من المستخدم.

قدرة التعلم الآلي على أتمتة حلقة التغذية المرتدة هذه مع تدخل بشري ضئيل أو معدوم أعادت تشكيل التجارة الإلكترونية، وقد تسمح يوما ما برؤية سيارات ذاتية القيادة بالكامل تتجول عبر الشوارع، على الرغم من أن هذا شكّل مشكلة أصعب بكثير مما توقع المهندسون. ولا يزال تطوير أسلحة ذاتية التشغيل مشكلة أكثر صعوبة.

عندما تواجه الخوارزميات معلومات غير متوقعة، فإنها غالبا ما تفشل في فهمها. المعلومات التي يمكن للإنسان فهمها بسهولة ولكن التعلم الآلي يسيء تصنيفها – حالة تعرف باسم “الأمثلة العدائية” – يمكن أن تؤدي إلى مضاعفة الأعباء بدلا من إيجاد حل لها.

حوافز للكذب

الغوص في تعقيدات التعلم الآلي يساعد على فهم المناقشات الدائرة حول الهيمنة التكنولوجية، ويفسر لماذا يعتقد المفكرون أن البيانات مهمة للغاية. كلما زاد عدد البيانات التي تخزنها زادت سرعة تحسن أداء الخوارزمية، فتكرار تغيير صغير يضاف إلى تغيير صغير آخر.. وهكذا، يفضي إلى نتيجة حاسمة. ولكن يبقى للتعلم الآلي حدوده أيضا.

ويصبح للعبارة المتداولة في عالم البرمجة “القمامة في المدخلات تعطي قمامة في المخرجات” معنى مختلف في عالم تؤثر فيه المدخلات على المخرجات والعكس. فدون تصحيح خارجي مناسب، يمكن لخوارزميات التعلم الآلي أن تكتسب نكهة القمامة التي تنتجها، وتولّد حلقة مغلقة من القرارات السيئة.

في الكثير من الأحيان، يتعامل صناع السياسات مع أدوات التعلم الآلي على أنها أدوات حكيمة وغير عاطفية. وبدلا من أن تكون أدوات معصومة من الخطأ يكتشفون فيما بعد أنها تضاعف المشكلات التي يزعمون حلها.

الأنظمة السياسية هي أنظمة تغذية مرتدة. في الديمقراطيات، يقوم الجمهور بتقييم القادة وترشيحهم لانتخابات يفترض أنها حرة ونزيهة. بينما تقدم الأحزاب وعودا بهدف الفوز بالسلطة والاحتفاظ بها، وتسلط المعارضة الضوء على أخطاء الحكومة، في حين تقدم الصحافة الحرة تقارير عن الخلافات، ويواجه شاغلو المناصب الناخبين ويتعلمون ما إذا كانوا قد اكتسبوا أو فقدوا ثقة الجمهور، في دورة يعاد تكرارها باستمرار.

لكن ردود الفعل في المجتمعات الديمقراطية لا تعمل دائما بشكل مثالي. فقد لا يكون لدى الجمهور فهم عميق للسياسة، ويمكن أن يعاقب الحكومات على أشياء خارجة عن إرادتها. أو قد يسيء السياسيون ومستشاروهم فهم ما يريده الجمهور.

أيضا، لدى المعارضة حوافز للكذب والمبالغة، مثال أن التنافس على الانتخابات يكلف المال، وأن القرارات الحقيقية تتخذ أحيانا خلف الأبواب المغلقة. وقد تكون وسائل الإعلام متحيزة أو تهتم بالترفيه عن مستهلكيها أكثر من اهتمامها ببنائهم.

ومع ذلك، فإن التغذية الراجعة تجعل التعلم ممكنا. السياسيون يتعلمون ما يريده الجمهور، ويتعلم الجمهور ما يمكن وما لا يمكن أن يتوقعه. ويمكن للناس انتقاد أخطاء الحكومة علنا دون أن يعرّضوا أنفسهم للاعتقال. ومع ظهور مشاكل جديدة، يمكن لمجموعات جديدة أن تطرح نفسها. كل هذا يسمح لصانعي السياسات والحكومات بالانخراط في عالم معقد ومتغير باستمرار.

في الأنظمة الاستبدادية تعمل التغذية الراجعة بشكل مختلف تماما. هنا لا يتم اختيار القادة من خلال انتخابات حرة ونزيهة، بل من خلال صراع على السلطة لا يرحم، وأنظمة ودساتير مبهمة في الكثير من الأحيان. وحتى عندما تكون معارضة للحكومة قانونية رسميا، فإنها لا تشجع على ذلك، بل غالبا ما تواجه المعارضة بوحشية. وإذا انتقدت وسائل الإعلام الحكومة، فإنها تخاطر باتخاذ إجراءات قانونية مصحوبة بالعنف أحيانا.

الانتخابات في مثل هذه الدول، إن حدثت، تميل بشكل منهجي لصالح شاغلي المناصب. أما المواطنون الذين يعارضون قادتهم جهرا فيواجهون عقوبات قاسية تصل إلى السجن أو حتى الإعدام. وغالبا ما تفتقر الحكومات الاستبدادية إلى فكرة واضحة عن كيفية عمل العالم أو ما تريده هي أو ما يريده مواطنوها.

ولذلك فإن هذه الأنظمة تواجه مقايضة بين الاستقرار السياسي قصير الأجل وصنع السياسات الفعالة؛ وغالبا ما يكون الاختيار لصالح الاستقرار السياسي، لأن السياسات

الفعالة تتطلب أن تكون لديها فكرة عمّا يحدث في العالم وداخل المجتمع.

وبسبب الضوابط المشددة على المعلومات، لا يستطيع الحكام المستبدون الاعتماد على المواطنين ووسائل الإعلام وأصوات المعارضة لتقديم ردود فعل تصحيحية، مثل ما هو متاح للقادة الديمقراطيين. والنتيجة أنهم يخاطرون بإخفاقات يمكن أن تقوض شرعيتهم وقدرتهم على الحكم. على سبيل المثال، القرار الكارثي الذي اتخذه الرئيس الروسي فلاديمير بوتين بغزو أوكرانيا كان يستند إلى تقييم غير دقيق لمعنويات أوكرانيا وقوة الجيش الروسي.

حتى قبل اختراع التعلم الآلي، استخدم حكام مستبدون مقاييس الكم كمصدر خام غير كامل لردود الفعل العامة. ولنأخذ على سبيل المثال الصين، التي حاولت لعقود طويلة الجمع بين اقتصاد السوق اللامركزي والإشراف السياسي المركزي على عدد قليل من الإحصاءات الحاسمة، وخاصة الناتج المحلي الإجمالي، حيث يمكن ترقية المسؤولين المحليين في حال شهدت مناطقهم نموا سريعا. لكن رؤية بكين المحدودة كميّا لم تقدم لهم حافزا يذكر لمعالجة قضايا ملتهبة مثل الفساد والديون والتلوث.

وليس غريبا أن يتلاعب المسؤولون المحليون في الكثير من الأحيان بالإحصاءات، أو يتبعون سياسات تعمل على تعزيز الناتج المحلي الإجمالي في الأمد القريب، وترك المشاكل طويلة الأجل لخلفائهم.

لا يختلف الذكاء الاصطناعي المرفوق بالتعلم الآلي كثيرا عن مادة البارود، فهو مادة خطرة طالما لم يتم الاتفاق على قوانين تنظم استخداماته. والى أن يتم الاتفاق على ذلك، سيبقى العالم بشقيه، الديمقراطي والدكتاتوري، مهددا.

.jpeg?token=44ff80a738e0863d44cc2f632f1e3cf2)

.jpeg?token=d43816333e7827f8423472f13bc62316)

.jpeg?token=c144f91a7d36305f97f933fa228f420c)

.jpeg?token=0f89eedcb96a891a00bab4ecf91e0123)

.jpeg?token=84761b6e33102a69e4ca4ffe06865edf)

.jpeg?token=2aed698faeafaa85ca857500b500cc2d)

.jpeg?token=e1a4c3bd087408207e1f916430ca9033)

.jpeg?token=2e718864f3091bcccfc90fa2b8a8f5fb)

.jpeg?token=bc4ad6eaeb7fd1d5e5fbbed0c76aff27)

.jpeg?token=1151b6feb11ba31d7f28f47c90cfcea1)

.jpeg?token=92ebed57ab60f9a9e67e8b34ed500f4d)

.jpeg?token=80966c5834ca01f30b8d973fbe8c7629)

.jpeg?token=3b957f353ce8f770ac4f0636c41c38a8)

.jpeg?token=88588a841cc7ab9e33572507928b33f1)